이번에 오픈랜 프로젝트와 관련한 AI-RAN 교육의 일환으로 연세대에서 AWS 관계자분들께 교육을 들었다.

AWS를 포함한 대기업들에서 바라보는 AI Fisrt 시대와, 앞으로 AI 시대에서 역량을 키우기 위해 어떤 대비를 해야하는지에 대한 Insight를 몇 가지 얻어 정리해보고자 한다.

AI FIRST 시대와 오픈소스

오픈소스는 이미 우리 일상 속에 있다

오픈소스는 더 이상 개발자만의 이야기가 아니다.

우리가 사용하는 아마존의 Kindle, 세탁기와 같은 IoT 기기, 그리고 각종 클라우드 서비스 곳곳에 오픈소스는 이미 깊숙이 스며들어 있다. 보이지 않을 뿐, 오늘날의 디지털 서비스는 오픈소스 없이는 돌아가기는 불가능한 구조이다.

특히 최근 몇 년 사이, 오픈소스는 단순한 코드 공유를 넘어 커뮤니티 중심의 생태계로 진화하고 있다.

이는 AI 시대와 맞물리며 더욱 가속화되고 있다.

AI FIRST 시대와 오픈소스의 재부상

AI 분야의 변화는 매우 빠르다. 현재 AI 연구와 산업 전반에서 파이썬이 사실상 표준 언어처럼 사용되고 있으며, 대부분의 핵심 프레임워크와 라이브러리가 오픈소스로 제공된다. 여기서 흥미로운 점은 AI 선두 주자들의 비즈니스 구조다.

OpenAI는 기술 영향력에 비해 매출 구조가 상대적으로 불안정한 반면,

기업용(B2B) 시장에서는 Anthropic의 Claude가 강세를 보이고 있다.

반면 Google은 여전히 B2C 시장에서 강력한 사용자 기반을 유지하고 있다.

오픈소스 재단의 위기와 새로운 전환점

AI가 많은 문제를 “자동으로 해결해주는” 시대가 오면서, 역설적으로 오픈소스 재단의 존립이 위협받고 있다.

“AI가 다 해주는데 굳이 오픈소스에 투자해야 할까?”라는 질문이 나오기 때문이다.

이런 상황에서 주목할 만한 사건이 있었다. Python Software Foundation이 설립된 지 10년이 넘었고, 최근 재정적 어려움이 언급되던 가운데, Anthropic이 대규모 기부를 결정했다는 발표가 나왔다.

이는 우리가 사용하는 프로그래밍 언어와 오픈소스 생태계가 AI 발전과 얼마나 밀접하게 연결되어 있는지를 상징적으로 보여주는 사례다.

글로벌 오픈소스 재단과 AI 인프라

오픈소스 커뮤니티는 대부분 비영리 재단 형태로 운영된다. 관심 있는 사람들이 모여 기술을 발전시키고, 기업은 이를 기반으로 서비스와 비즈니스를 만든다.

대표적인 예가 Linux Foundation이다. 이 재단은 하나의 거대한 우산(Umbrella) 역할을 하며 다양한 프로젝트를 품고 있다.

- PyTorch Foundation – AI·딥러닝 핵심 프레임워크

- OpenInfra Foundation – 인프라 오픈소스 생태계

- CNCF (Cloud Native Computing Foundation) – 클라우드 네이티브, 컨테이너 기술의 중심

그리고 최근, 이 흐름의 연장선에서 Agentic AI Foundation이 리눅스 파운데이션 산하로 출범했다.

이 재단을 적극 지지한다고 발표한 기업이 바로 Amazon Web Services(AWS)다.

AWS에서는 “Agentic AI 시대는 오픈소스 기반의 연구와 협업이 필수”인 것으로 바라보고 있다.

AWS와 오픈소스의 공진화 (+컨테이너와 쿠버네티스)

AWS는 오픈소스와 떼려야 뗄 수 없는 관계 속에서 성장해왔다.

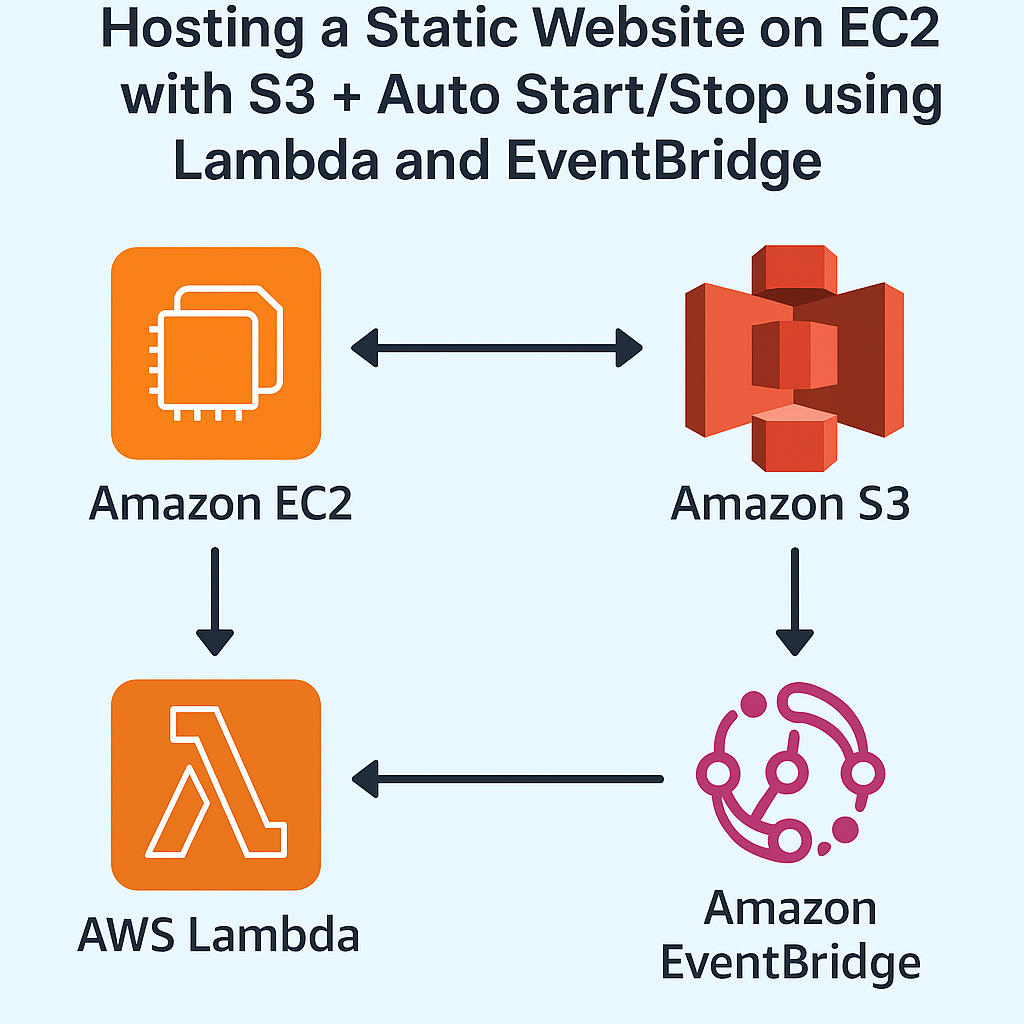

- EC2: 초기에는 Xen 기반 → 현재는 KVM 중심

- S3: 리눅스 기반 스토리지 아키텍처

- Lambda: OpenJDK 적극 활용

컨테이너 자원이 폭발적으로 늘어나면서, 이를 효율적으로 관리하기 위한 기술이 중요해졌고, 그 중심에 Kubernetes가 있다.

AI는 컨테이너 위에서 돌아간다

오늘날 주요 AI 기업들은 대부분 쿠버네티스 기반 인프라를 사용한다.

- Anthropic: EKS 기반 학습·추론

- Hugging Face: 컨테이너 기반 추론 환경

- OpenAI: 쿠버네티스 기반, 주요 고객은 Microsoft와 Oracle

공식적으로 명확히 언급되지는 않았지만, 이후 Microsoft가 OpenAI가 Azure Kubernetes Service를 사용한다고 발표하면서 사실상 확인되었다.

컨테이너 기술은 이제 단순한 배포 수단을 넘어, 대규모 시뮬레이션, 논문 실험, AI 추론까지 모두 아우르는 핵심 도구가 되었다.

특히 글로벌 컨퍼런스에서는 “대규모 스케일에서 검증했다”는 점이 연구 채택 가능성을 크게 높인다.

연구자와 기업이 오픈소스를 활용하는 방식

오픈소스를 둘러싼 선택지는 다양하다.

- 기업의 경우:

- 순수 오픈소스 사용

- 오픈소스 기반 상용 솔루션 활용

- 자체 서비스와의 결합

- 연구자의 경우:

- 연구 결과를 오픈소스로 공개해 관심 유도

- 커뮤니티 형성 → 연구 고도화

- 기업과 협업해 지속 가능한 구조로 발전

최근 AI-RAN과 같은 분야에서도 Alliance 중심의 오픈소스가 등장하는 것은 이런 흐름과 무관하지 않다.

이처럼 오픈소스는 AI 시대의 핵심 인프라다.

장기적으로 보면, 대한민국에서도 오픈소스가 기업의 성장과 협업 속에서 자연스럽게 발전하는 모델로 정착할 수 있는지가 매우 중요한 요소로 작용할 수 있다.

'Cloud & Edge 인프라 > AWS Cloud Platform' 카테고리의 다른 글

| AWS AI First 전략: Container에서 분산 AI Infrastructure까지 (0) | 2026.01.15 |

|---|