LangChain이란 무엇인가?

LangChain 공식 홈페이지: https://docs.langchain.com/oss/python/langchain/overview

LangChain overview - Docs by LangChain

docs.langchain.com

LangChain은 LLM(Large Language Model) 기반 Agent 및 Application을 가장 쉽게 구축할 수 있는 Framework이다.

2023년에 ChatGPT의 등장으로 LLM은 폭발적인 관심을 끌었다.

ChatGPT는 GPT라는 매우 똑똑한 모델과 1:1 채팅을 할 수 있는 훌륭한 플랫폼이다.

여기서 한가지 질문이 생기는데, ChatGPT를 단순한 모델과의 채팅으로만 쓰기에는 너무 아깝다는 것.

예를 들어, 아래와 같은 다양한 활용방안을 생각할 수 있다.

- 여행 서비스를 운영한다면 여행 일정을 자동으로 설계해주는 GPT

- 차량 렌탈 서비스를 한다면 고객 응대를 담당하는 GPT

- 사내 문서를 관리한다면 문서 기반 질의응답 시스템

만약 ChatGPT와 같은 LLM을 우리의 애플리케이션에 연결하려면 수백, 수천 줄의 코드를 필요로 하겠지만,

LangChain 라이브러리를 사용하면 10줄 미만의 코드로도 OpenAI, Anthropic, Google 등 다양한 LLM 플랫폼에 연결할 수 있다.

즉, LangChain 자체가 똑똑한 AI인 것이 아니라, LangChain은 GPT와 같은 LLM과 우리가 만들고 싶은 서비스 로직을 'Chain'으로 엮어주는 역할을 한다.

만약 문서 기반 QA 시스템을 만든다고 가정을 해보자.

PDF, Word, 한글 파일, 웹 문서 등을 그대로 GPT에 넣을 수는 없다.

먼저 문서를 읽고, 텍스트를 추출하고, 쪼개고, 임베딩하고, 검색 가능한 형태로 만들어야 한다.

이 과정을 파이썬 코드로 처음부터 구현하면 코드가 매우 길어진다.

하지만 LangChain을 사용하면, 문서 로딩 (Loader), 텍스트 분할, 임베딩, 벡터 데이터베이스 연동의 모든 과정이 한두 줄의 코드로 가능하다.

LangChain 생태계 총정리 (LangChain, LangGraph, LangSmith)

LLM 기반 애플리케이션을 만들다 보면 단순히 “답변을 잘한다”는 것만으로는 부족하다는 걸 곧 깨닫게 됩니다.

왜 그런 답변이 나왔는지, 어디서 정보를 가져왔는지, 어떤 흐름으로 추론이 진행됐는지, 그리고 이걸 실제 서비스로 어떻게 배포할 것인지까지 모두 고려해야 하기 때문입니다.

LangChain 생태계는 바로 이 문제를 해결하기 위해 만들어졌습니다.

1. LangChain 개요 – LLM 애플리케이션의 출발점

LangChain은 LLM(Large Language Model) 기반 에이전트 및 애플리케이션을 가장 쉽게 구축할 수 있는 프레임워크이다.

10줄 미만의 코드만으로 OpenAI, Anthropic, Google 등 다양한 LLM 플랫폼에 연결할 수 있으며, 사전 구축된 Agent 아키텍처와 모델 통합 기능을 제공하여 LLM을 애플리케이션에 빠르고 안정적으로 통합할 수 있도록 도와준다.

에이전트나 자율 애플리케이션을 빠르게 만들고 싶다면 LangChain이 가장 적합한 선택이다.

복잡한 로직을 직접 구현하지 않아도, 기본적인 LLM 호출, 프롬프트 구성, 응답 처리까지 자연스럽게 연결할 수 있다.

2. LangGraph 개요 – 저수준 에이전트 오케스트레이션

LangGraph는 Klarna, Replit, Elastic 등 에이전트 기반 서비스를 선도하는 기업들도 많이 채택한 저수준 Agent Orchestration Framework이자 Runtime입니다.

LangGraph의 특징은 다음과 같습니다.

- 장기 실행되는 상태 저장(Stateful) 에이전트 지원

- 결정론적 워크플로 + 에이전트 워크플로 조합 가능

- 스트리밍, 인간 개입(Human-in-the-loop), 안정적인 실행 보장

LangGraph는 매우 Low-level이기 때문에, 모델과 도구, 에이전트 구성 요소에 대한 이해가 필요하다.

따라서 에이전트를 처음 접하거나 높은 추상화를 원한다면 LangChain 에이전트를 먼저 사용하는 것이 좋다.

참고로, LangChain의 에이전트 기능은 내부적으로 LangGraph를 기반으로 구현되어 있다.

3. LangSmith – LLM 애플리케이션의 관측과 평가

ChatGPT는 질문을 던지면 바로 답변을 준다.

하지만 서비스를 개발하는 입장에서는 그 과정이 보이지 않는 것이 LLM Service 개발과정의 큰 문제이다.

예를 들어,

- 문서 기반 QA에서 문서의 어느 부분을 검색했는지

- 실제 Prompt에는 어떤 형태로 입력이 들어갔는지

- 답변이 좋지 않았다면 어느 단계에서 문제가 발생했는지

이런 것들을 알 수 없다면, 서비스를 개선하는 것도 불가능하다.

LangSmith는 바로 이 문제를 해결하기 위한 Framework다.

LangSmith가 제공하는 기능은 아래와 같다

- 요청(Request) 및 응답(Response) 추적

- 프롬프트 버전 관리 및 테스트

- 출력 결과 평가(Evaluation)

- 디버깅 및 배포 관리

LangSmith는 프레임워크에 종속되지 않기 때문에,

LangChain, LangGraph와 함께 사용해도 되고 단독으로 사용해도 된다.

로컬에서 프로토타입을 만든 뒤, LangSmith를 통해 관측 가능하고 신뢰할 수 있는 프로덕션 AI 시스템으로 발전시킬 수 있다.

4. LangServe – 만든 서비스를 실제로 배포하기

AI 서비스를 만들었다면, 거기서 끝이 아니다.

“우리만 쓰고 끝낼 것인가,

아니면 웹 서비스로 배포할 것인가?”

LangServe는 LangChain 기반 애플리케이션을 매우 쉽게 Hosting할 수 있도록 도와주는 도구이다.

복잡한 서버 코드를 직접 작성하지 않아도, 우리가 만든 체인을 API 형태로 배포할 수 있다.

- 빠른 프로토타이핑

- 간단한 배포

- 실제 서비스로 확장 가능

단순한 프로젝트에서 실제 서비스로 넘어가는 다리 역할을 한다고 볼 수 있다.

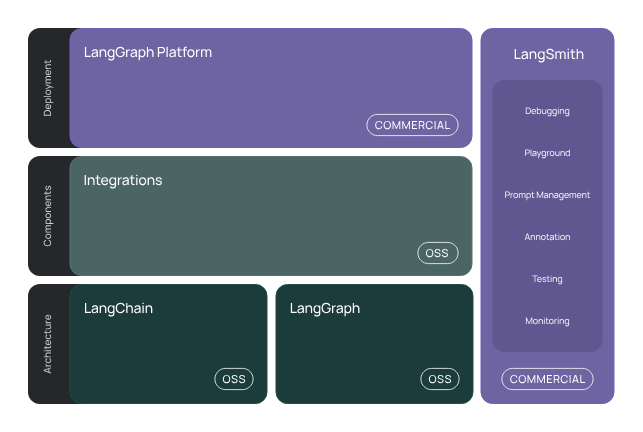

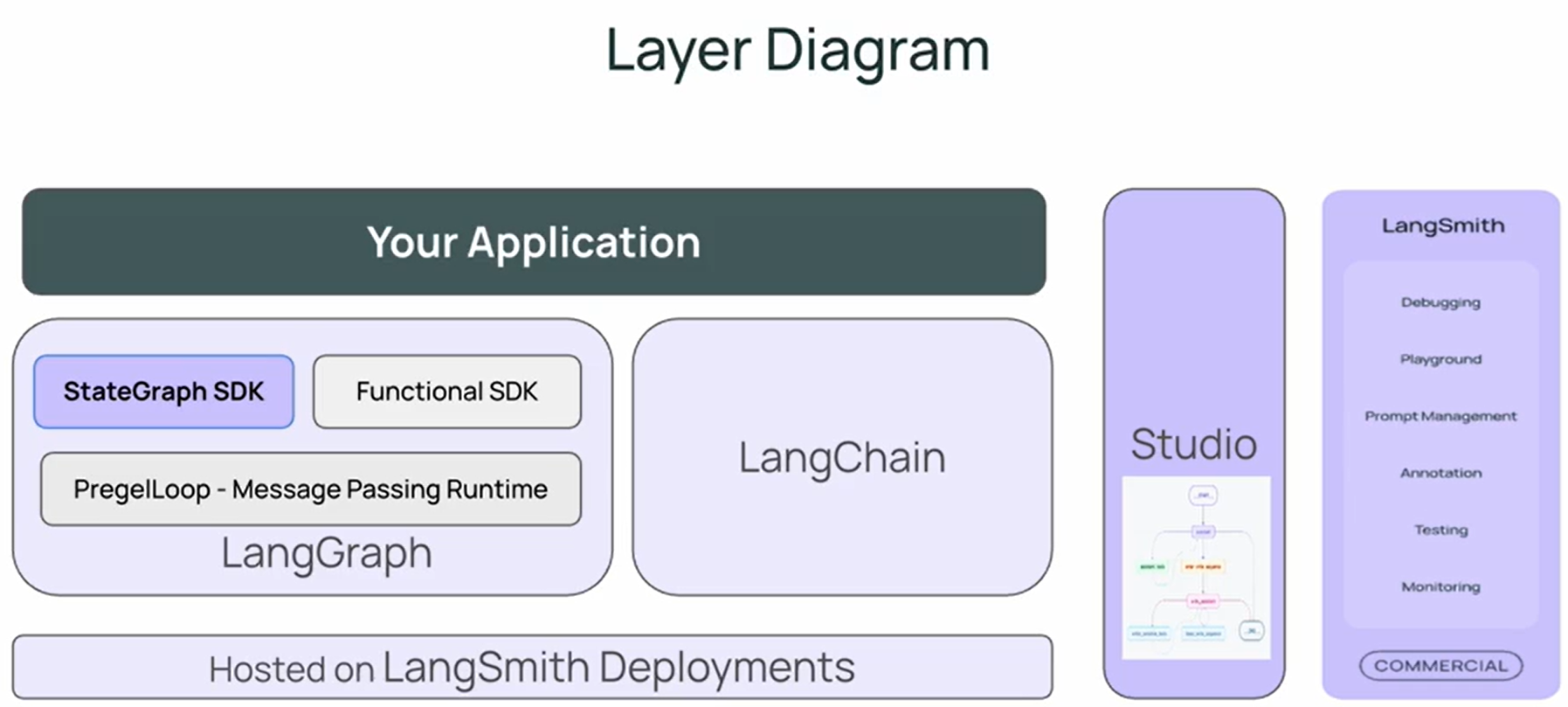

전체적인 Layer를 정리하면 아래와 같다.

LangGraph의 구성 요소는 2개의 사용자 SDK로 구성된다.

여기서 많이 쓰이는 것은 StateGraph SDK로, 이것이 LangGraph로 불린다.

LLM, Tool, Component들은 LangChain 라이브러리에서 제공된다.

이런 LangGraph와 LangChain 위에서 우리의 Application이 실행되는 것.

이는 LangSmith 배포를 통해 Hosting되며, Studio와 LangSmith는 유용한 디버깅, 평가 및 테스트 기능을 제공한다.

LangChain 핵심 로직

LangChain은 단일 라이브러리가 아니라 하나의 생태계입니다.

LangChain을 구성하는 주요 영역은 다음과 같다.

1. LangChain Core

LangChain의 가장 기본이 되는 핵심 라이브러리이다.

LLM과 대화하는 최소 단위부터, 하나의 질의–응답 흐름이 어떻게 구성되는지를 다룬다.

다음으로 구성되어 있다.

- LLM 호출 : OpenAI, Anthropic, Google 등 다양한 LLM을 일관된 인터페이스로 호출 (모델별 API 차이 신경 쓸 필요 X)

- Prompt 구성 : 구조화된 Prompt 설계 (System / Human / AI 메시지 분리 + 입력 변수 기반 Prompt 템플릿화)

- Chain 구조 : LLM 호출을 하나의 단계로 보지 않고 여러 단계를 연결 ( 입력 → 처리 → 출력의 흐름을 명확히 정의)

2. LangChain Community

LangChain의 확장 생태계를 담당하는 영역이다.

- OpenAI GPT뿐 아니라 다양한 LLM 사용 : OpenAI GPT뿐 아니라 Anthropic Claude, Google Gemini, 로컬 LLM 등

(모델만 바꿔도 코드 구조는 거의 동일) - 외부 모델 · 임베딩 · 툴 연동 (다양한 임베딩 모델 선택 가능 + 외부 API, 검색 엔진, 계산 모듈 연동 등)

특히 이 중 Retrieval은 RAG의 핵심 요소이다.

RAG는 LLM이 모르는 정보를 어디서 어떻게 가져올지를 정의한다.

- 어떤 DB를 쓸 것인가? 어떤 검색 알고리즘을 쓸 것인가? 문서를 어떻게 분할하고 검색할 것인가?

Agent는 LLM이 단순히 답변만 하는 존재를 넘어, 행동하는 주체가 되는 단계이다.

- Tool로는 인터넷 검색 도구나 계산기 등을 사용할 수 있는데 Agent는 직접 도구를 선택하고 실행한다.

- 또한 역할이 다른 Agent를 분리한 다중 Agent 협업 구조를 활용할 수 있다. (LangGraph와 함께 사용 시 강력)

3. Reference Application의 Template

이 부분은 빠른 실습과 Prototyping을 위한 영역이다

- 미리 만들어진 템플릿 활용 (문서 QA, 챗봇, RAG 기반 서비스, Agent 기반 Application 등)

- 약간의 수정만으로 서비스 구현 가능 (Prompt 일부 수정, Data source 교체, LLM Model 변경)

- LangServe와 바로 연동 가능 (Template → API 서버로 곧바로 배포 가능)

4. LangSmith 기반 Monitoring + Evaluation

이 부분은 Prompt별 출력 비교하고, 응답 품질은 점검하여 추론 과정 추적을 가능하게 한다.

이는 곧 LLM 애플리케이션의 품질과 신뢰성과 직결된다.

- 외부 라이브러리와 병행 사용이 가능

- 정량 평가 (정확도, 일관성) + 정성 평가 (사람 평가) + 실험 반복 및 비교

'Agentic AI 구축 > LangChain & LangGraph' 카테고리의 다른 글

| [LangGraph 기초 2] Edge의 개념 (병렬 실행과 분기) (0) | 2026.01.03 |

|---|---|

| [LangGraph 기초 1] Node와 State의 개념 (0) | 2026.01.03 |

| LangChain에서 HuggingFace의 오픈소스 LLM 모델 (Llama 시리즈) 사용하기 (0) | 2025.12.11 |

| LangChain의 한계와 이를 보완하기 위한 LangGraph의 구조 (0) | 2025.11.19 |

| LangChain에서의 MCP 구현 설명 (@tool의 의미) (0) | 2025.11.05 |