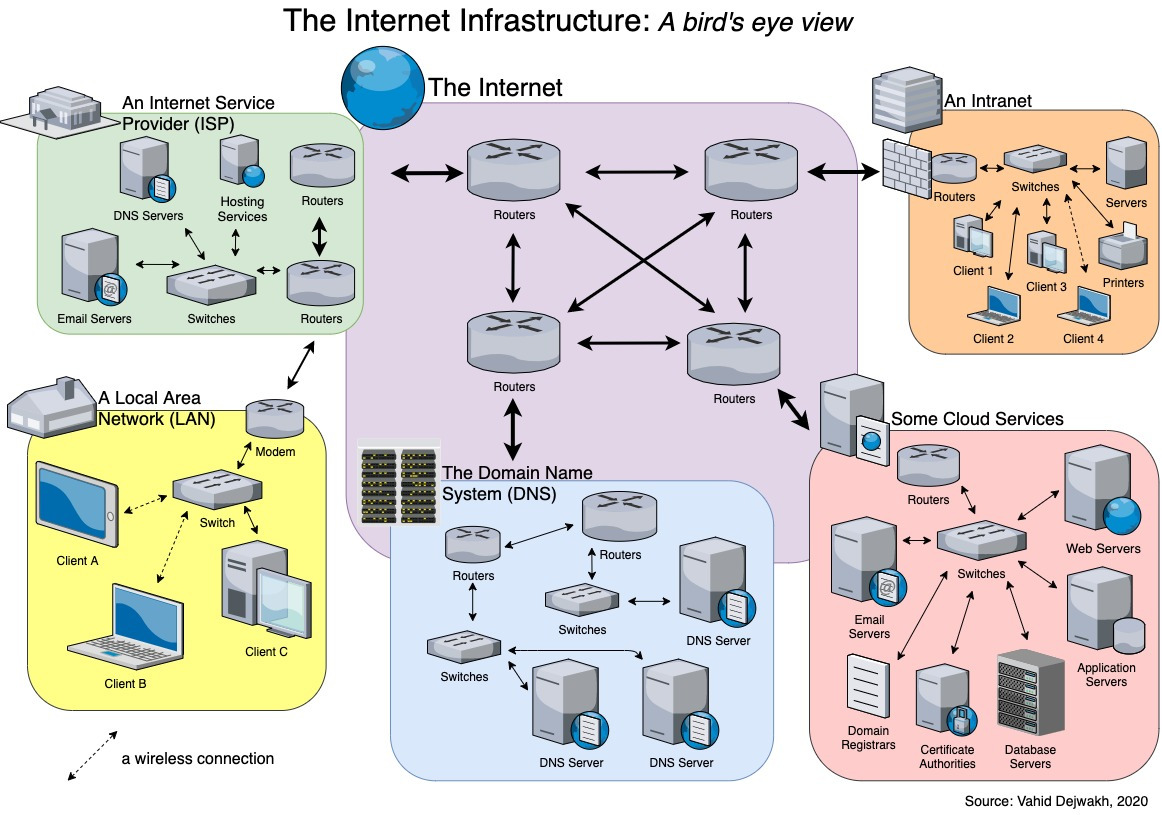

AWS, Google Cloud, Microsoft Azure와 같은 하이퍼스케일 클라우드 사업자들이 구성하는 Network Topology를 이해하는 것은 Network를 공부하는 데 있어 중요하다.

이들의 네트워크는 단일 데이터센터 수준을 넘어, 물리적 Data Center에서 시작해 전 세계 Region을 연결하는 초대규모 광섬유 Backbone 위에 계층적으로 설계된 구조다. 이는 단순히 서버를 연결하는 네트워크가 아니라, 전 세계 사용자에게 서비스를 전달하기 위해 구축된 하나의 통신 인프라에 가깝다.

이 구조는 크게 Data Center, Region, 그리고 Global Backbone이라는 세 단계로 나누어 이해할 수 있다.

Data Center

먼저 Data Center는 가장 기본 단위다.

Data Center는 클라우드 인프라에서 가장 기본이 되는 물리적 공간이다.

하나의 Data Center 안에는 수만 대의 Server가 설치되어 있으며, 이 서버들은 바닥에 흩어져 있는 것이 아니라 Rack이라는 금속 프레임에 일정한 규격으로 묶여 배치된다.

하나의 Rack에는 보통 수십 대의 Server가 들어가고, 이런 Rack이 데이터센터 내부에 수백~수천 개 단위로 반복 배치된다.

이 Rack 안에 들어 있는 Server는 모두 하나의 Network 장비에 연결되는데, 이것에 Top-of-Rack 스위치이다.

이름 그대로 Rack의 맨 위에 위치하며, 해당 Rack에 속한 모든 Server들의 네트워크 연결을 한 곳에서 모아주는 역할을 한다.

Aggregation Switch라고 부르기도 한다.

즉, Server 입장에서 보면 외부 네트워크로 나가는 첫 번째 관문이 Top-of-Rack 스위치다.

하지만 한 Rack 안의 Server끼리만 통신하는 경우는 드물다.

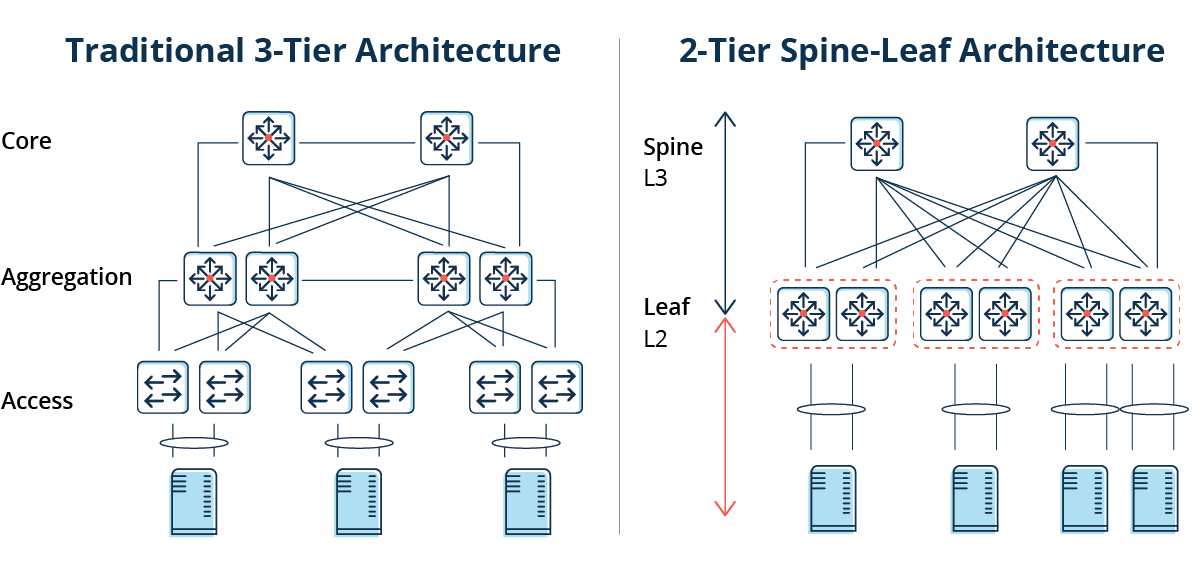

실제 서비스에서는 웹 서버, 캐시 서버, 데이터베이스 서버 등이 서로 다른 Rack에 흩어져 있고, 이들 사이에 끊임없는 통신이 발생한다. 이를 처리하기 위해 Top-of-Rack 스위치들은 Spine–Leaf 구조로 연결된다.

여기서 Leaf는 각 Rack에 붙어 있는 Top-of-Rack 스위치들을 의미하고, Spine은 이 Leaf 스위치들을 위에서 한 단계로 모두 연결하는 상위 스위치 계층이다. 중요한 점은 Leaf 스위치끼리는 직접 연결되지 않고, 항상 Spine 스위치를 경유해 통신한다는 것이다. 그래서 어떤 Rack의 Server든 다른 Rack의 Server로 갈 때 항상 “Leaf → Spine → Leaf”라는 동일한 형태의 경로를 갖는다.

이러한 구조는 데이터센터 내부에서 서버 간 통신을 매우 빠르고 예측 가능하게 만든다.

특히 클라우드 환경에서는 사용자 요청보다 서버와 서버 사이의 내부 통신이 훨씬 많다.

예를 들어, 웹 서버가 데이터베이스 서버를 호출하고, 로그를 수집 서버로 보내며, AI 모델 서버가 다른 서비스 서버와 대화하는 식이다. 이런 내부 서버 간 트래픽을 East-West Traffic이라고 부른다.

Spine–Leaf Topology는 바로 이 East-West Traffic을 높은 Bandwidth와 낮은 Latency로 처리하기 위해 설계된 구조다.

Region

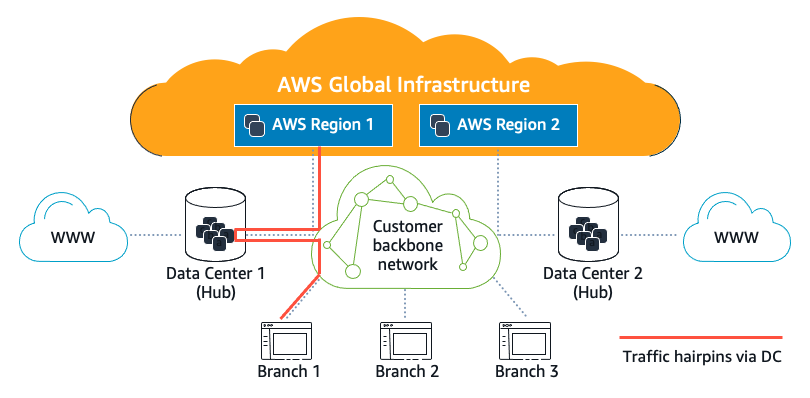

그런데 Datacenter 하나만으로는 대규모 클라우드 서비스를 안정적으로 제공하기 어렵다.

전원 장애, 화재, 침수 같은 물리적 사고가 발생하면 그 Datacenter 전체가 영향을 받을 수 있기 때문이다.

그래서 Cloud 사업자들은 여러 Datacenter를 묶어서 하나의 더 큰 단위로 관리하는데, 이 단위가 Region이다.

AWS에서의 Region은 지리적으로 가까운 여러 Datacenter 묶음을 뜻한다.

이때 Region 안의 Datacenter들은 다시 Availability Zone, 줄여서 AZ라는 단위로 나뉜다.

AWS 홈페이지에 들어가면, 서울은 아시아 태평양 Region에 속해있고, 여기에 Availabity Zone는 4개로 확인된다.

즉, AZ 하나는 보통 하나 이상의 Datacenter로 구성되며, 중요한 점은 AZ들끼리는 물리적으로 분리되어 있다는 것이다.

같은 Region 안에 있어도, 서로 다른 AZ는 전원 공급원, 냉각 시스템, 건물 위치까지 독립적이다.

즉, 한 AZ가 완전히 죽어도 다른 AZ는 정상 동작하도록 설계되어 있다.

하지만 분리만 해두면 서비스 운영이 어렵다.

실제 서비스는 여러 AZ에 걸쳐 분산되어 동작해야 하고, 그 사이에 데이터와 트래픽이 계속 오가야 한다.

그래서 Region 내부에서는 퍼블릭 인터넷이 아니라 전용 광섬유 링크를 사용한다.

이 광섬유는 일반 ISP 인터넷 회선을 빌려 쓰는 것이 아니라, 클라우드 사업자가 직접 깔거나 장기 임대한 선로이다.

외부 인터넷 라우터를 거치지 않고, 오직 해당 Region 내부 통신만을 위해 사용되는 폐쇄형 네트워크다. 이 네트워크를 흔히 Region 내부 Backbone이라고 부른다.

이 Backbone의 대역폭 규모는 우리가 흔히 생각하는 네트워크 수준을 훨씬 넘는다.

수십에서 수백 Tbps급 링크들이 다중으로 구성되어 있으며, 특정 AZ 간 트래픽이 몰려도 병목이 생기지 않도록 설계되어 있다.

또한 경로가 고정적이고 통제 가능하기 때문에, Latency와 Jitter가 매우 예측 가능하다.

이 구조 덕분에, 같은 Region 안의 서로 다른 AZ에 있는 서버끼리 통신할 때는 “멀리 떨어진 인터넷 서버와 통신한다”는 느낌이 거의 없다. 물리적으로는 몇 km에서 수십 km 떨어져 있을 수 있지만, 네트워크 관점에서는 하나의 거대한 데이터센터처럼 동작한다.

Global Backbone

Region과 Region은 물리적으로 매우 멀리 떨어져 있다.

서울 Region과 도쿄 Region, 도쿄와 오레곤, 오레곤과 프랑크푸르트처럼 대륙을 넘나드는 거리다.

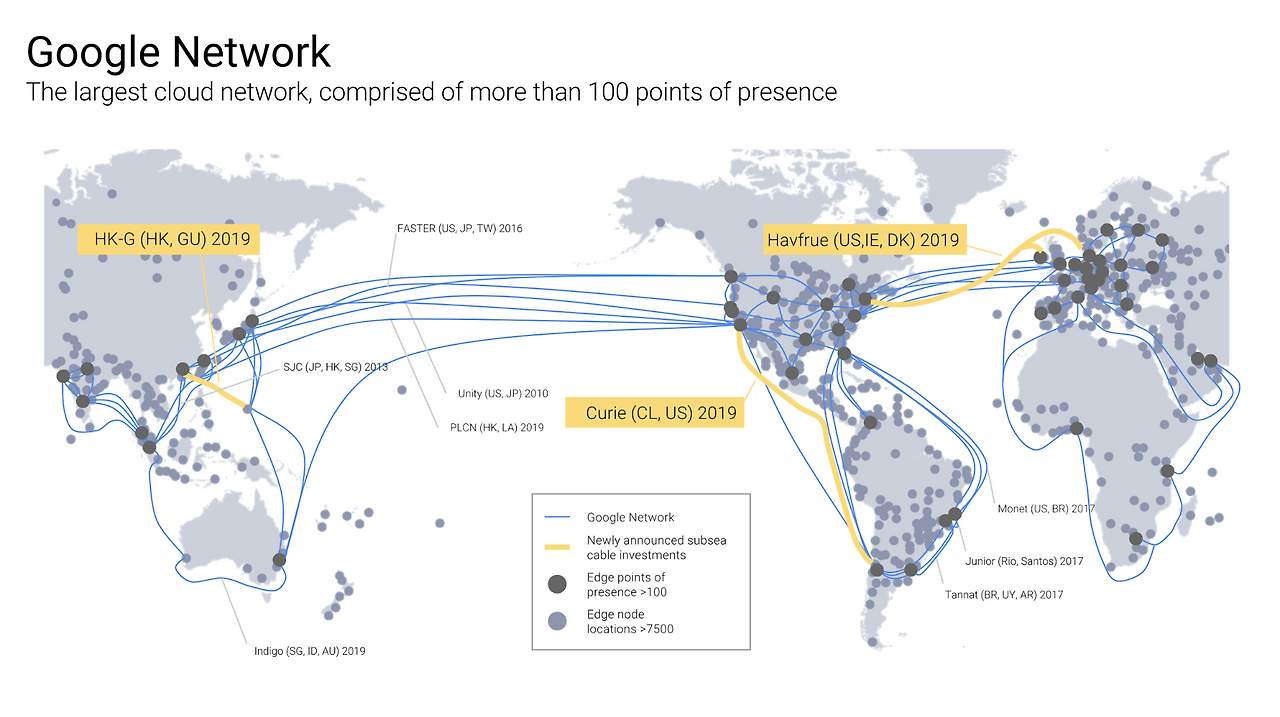

이 Region들을 연결하는 네트워크가 바로 글로벌 Backbone이다.

AWS, Google, Meta와 같은 Hyper Scale사업자들은 이 구간에서 일반 ISP가 제공하는 퍼블릭 인터넷 경로에만 의존하지 않는다.

대신 대륙 간 해저 광케이블을 직접 구축하거나 케이블 컨소시엄에 참여해 지분을 확보하고, 대륙 내부에서도 주요 도시를 잇는 장거리 광섬유를 직접 소유하거나 장기 임대한다.

그 결과, 전 세계 Region들을 자기들만의 거대한 사설 네트워크처럼 연결할 수 있는 기반을 갖추게 된다.

이 Global Backbone의 라우팅은 표면적으로는 BGP 기반으로 동작한다.

전 세계 규모에서 수천 개의 네트워크 노드를 연결하고, 링크 장애 발생 시 자동으로 우회할 수 있는 사실상 유일한 글로벌 표준이 BGP이기 때문이다.

따라서 외형만 보면 일반 인터넷과 동일한 라우팅 메커니즘을 사용하는 것처럼 보인다.

하지만 이 지점에서 일반 ISP 기반 인터넷과 결정적인 차이가 나타난다.

Public Internet에서는 각 ISP가 자신이 속한 네트워크 구간만을 통제하며, 트래픽 경로 선택 역시 비용, 계약 관계, 피어링 구조 등 개별 사업자의 정책에 따라 분산적으로 결정된다.

이 때문에 전체 Topology를 한 곳에서 파악하거나, 전역적인 트래픽 흐름을 의도대로 제어하기는 어렵다.

반면 하이퍼스케일 사업자는 Global Backbone의 상당 부분을 직접 소유하거나 통제한다.

즉, 어느 Region에서 어느 Region으로 트래픽이 얼마나 흐르는지, 특정 해저 케이블이나 장거리 링크에 혼잡이나 오류 징후가 있는지, 어느 구간이 장애에 취약한지를 내부적으로 실시간에 가깝게 파악할 수 있다.

이러한 가시성을 바탕으로, 하이퍼스케일 사업자들은 BGP 위에 SDN 성격의 Control Plane을 얹어 운용한다.

이 Control Plane은 개별 패킷을 직접 다루기보다는, “이 트래픽 군은 태평양 케이블 A를 우선 사용하고, 혼잡 시 케이블 B로 분산한다”거나 “장애 가능성이 감지된 구간은 사전에 우회한다”와 같이 전역적인 Traffic flow을 중앙에서 결정한다.

실제 패킷 전달은 여전히 분산된 Router들이 수행하지만, 경로 선택의 방향성과 우선순위는 중앙 정책에 의해 조정된다.

결과적으로 Global Backbone은 인터넷 표준 라우팅 기술을 사용하면서도, 운용 방식은 훨씬 중앙집중적이다.

이는 Hyperscale 사업자가 단순히 인터넷 위의 서비스 제공자가 아니라, 전 세계 규모의 통신망을 직접 운영하는 주체에 가깝다는 점을 보여준다. 이런 구조 덕분에 대륙을 넘는 통신에서도 지연은 물리적 거리 수준으로 제한되고, 예측 불가능한 경로 변동이나 품질 저하는 최소화된다.